Avec l’adoption du Règlement (UE) 2024/1689 dit AI Act, l’Union européenne a franchi une étape historique dans la régulation de l’intelligence artificielle, en mettant en place le premier cadre juridique global visant à encadrer la conception, la mise sur le marché et l’utilisation des systèmes d’IA. Ce texte, entré en vigueur en août 2024, repose sur une approche fondée sur le niveau de risque que présentent les applications d’IA pour la santé, la sécurité et les droits fondamentaux des personnes.

Une distinction entre différents niveaux de risque

L’AI Act distingue ainsi plusieurs catégories de systèmes d’IA, chacune donnant lieu à des obligations juridiques spécifiques.

- Au sommet de cette hiérarchie figurent les systèmes présentant un risque inacceptable : ces usages, tels que la notation sociale, la manipulation comportementale ou certains dispositifs de reconnaissance faciale en temps réel, sont strictement interdits sur le marché de l’Union européenne afin de prévenir des atteintes graves aux droits fondamentaux.

- Viennent ensuite les systèmes à haut risque, qui ne sont pas prohibés mais doivent satisfaire à un ensemble de contraintes renforcées avant d’être commercialisés ou déployés. Ces obligations comprennent notamment une évaluation rigoureuse des risques, des procédures de gestion des biais et de qualité des données, des mécanismes de contrôle humain, ainsi qu’une documentation détaillée et traçable du fonctionnement du système. Sont visés par cette catégorie des usages variés dans des secteurs sensibles tels que la santé, l’éducation, l’emploi, les services essentiels ou encore la justice et l’ordre public.

- À un niveau intermédiaire, l’AI Act identifie des systèmes à risque limité, pour lesquels les obligations se concentrent essentiellement sur la transparence à l’égard des utilisateurs : il s’agit, par exemple, de veiller à ce que ces derniers soient informés qu’ils interagissent avec une IA ou que le contenu a été généré par une intelligence artificielle.

Il n'existe pas de catégorie représentant des risques minimaux ou nuls dans l'AI Act. La vaste majorité des systèmes (tels que les filtres anti‑spam ou les jeux vidéo intégrant de l’IA) appartiennent à cette catégorie et ne nécessitent donc pas d'obligations particulières, même si les bonnes pratiques volontaires sont encouragées.

Dans les catégories mentionnées, l’enjeu pour les organisations n’est pas seulement d’identifier abstraitement le niveau de risque d’un système d’IA, mais bien de recenser, qualifier et documenter concrètement chaque cas d’usage, afin de déterminer avec précision le régime juridique applicable et les obligations qui en découlent.

Cette exigence implique la mise en place d’une méthodologie structurée de cartographie des cas d’usage d’IA, permettant de passer d’une lecture théorique de l’AI Act à une application opérationnelle et maîtrisée en pratique.

Cartographier les systèmes d’IA avec DASTRA

La cartographie permet aux entreprises et organisations de visualiser l’ensemble des systèmes d’IA déployés, d’identifier les obligations légales applicables et de prioriser les actions de conformité.

La démarche repose sur trois grands axes : identification, classification et documentation.

Pour qu’une cartographie des cas d’usage d'IA soit véritablement opérationnelle, elle doit dépasser la simple liste descriptive et devenir un référentiel structuré, relié à la réalité des systèmes, des données et des obligations réglementaires. DASTRA répond précisément à ce besoin en offrant des fonctionnalités permettant de documenter, classifier et suivre les systèmes d’IA dans leur contexte organisationnel et réglementaire.

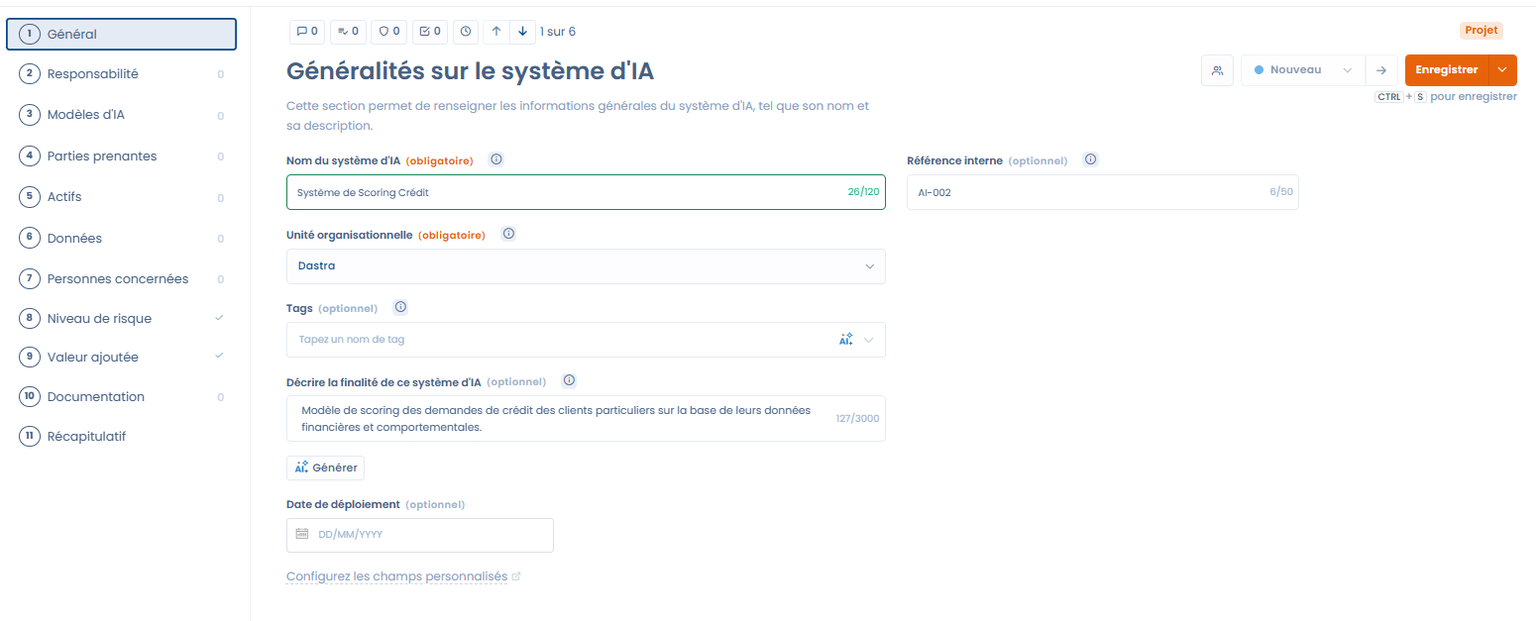

1. Créer un registre initial des systèmes d’IA

La première étape consiste à recenser l’ensemble des systèmes d’IA utilisés ou développés, en prenant en compte non seulement les logiciels internes, mais également les solutions fournies par des tiers ou en mode SaaS. Ce recensement doit intégrer les systèmes en production, en phase de test, de preuve de concept (POC) ou de déploiement, afin d’éviter les angles morts fréquemment observés lors des audits.

Chaque système doit être décrit selon plusieurs dimensions , telles que la finalité du système (ex. détection de fraude), la technologie utilisée, le bénéficiaire et la sensibilité des données traitées.

Dans DASTRA, chaque système d’IA peut être représenté par une fiche dédiée, qui constitue le point d’entrée central de la cartographie.

Cette fiche permet notamment :

Cette fiche permet notamment :

d’associer le système aux actifs techniques déjà identifiés dans la cartographie des données (applications, APIs, infrastructures) ;

de lier les jeux de données utilisés ou générés, facilitant l’analyse des impacts au regard du RGPD et de l’AI Act ;

d’identifier les parties prenantes clés (responsable métier, responsable de traitement, sous-traitant, éditeur) ;

et de qualifier le statut du système (interne/externe, en cours de déploiement, arrêté), garantissant une cartographie exhaustive et à jour.

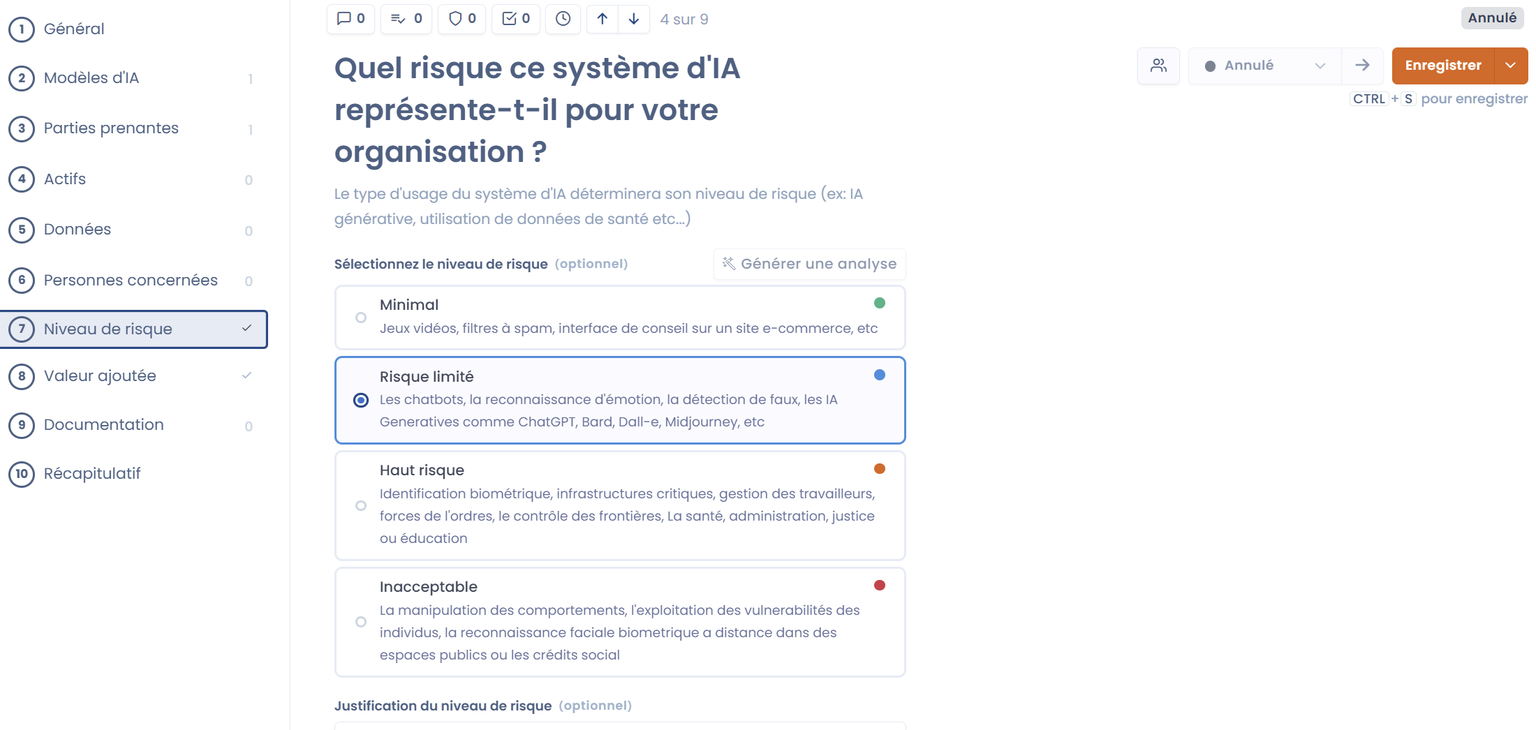

2. Classer les systèmes d’IA selon le niveau de risque

La seconde étape consiste à déterminer la catégorie du système d'IA utilisé, afin d'avoir une approche différenciée par niveau de risque.

Dans DASTRA, il est possible de lier chaque système à sa catégorie de risque directement dans sa fiche. L’outil permet également de documenter les critères ayant conduit à la classification, mais également d'évaluer la valeur ajoutée de chaque système, afin de faciliter les décisions d’arbitrage.

3. Documenter les obligations et assurer le suivi

3. Documenter les obligations et assurer le suivi

Pour chaque système d’IA identifié et classé, il est nécessaire de documenter les obligations et exigences associées, telles que les obligations réglementaires applicables, ou encore les processus opérationnels internes.

Dans DASTRA, cette documentation s’effectue directement au sein de la fiche du système d’IA. Il est recommandé d'intégrer une notice de transparence (ou notice d'information) afin de préparer et centraliser les informations destinées aux utilisateurs finaux. Cela permet de garantir que la finalité du système, les données utilisées et les droits des personnes concernées sont correctement communiqués.

4. Analyser les interdépendances et impacts des systèmes d’IA

Une cartographie doit également identifier les interactions entre systèmes, la dépendance aux données et l’impact potentiel sur les droits fondamentaux. Par exemple, un système de recommandation utilisant des données de santé personnelles pourrait, selon sa finalité, basculer d’un risque limité à un risque élevé, nécessitant un suivi renforcé.

Dans DASTRA, cette analyse est facilitée par plusieurs fonctionnalités. Il est ainsi possible, notamment, de visualiser la cartographie et de voir les liens entre les systèmes, les actifs et les jeux de données, offrant une vue d’ensemble des flux et des dépendances critiques. Les interactions avec les jeux de données et les modèles d’IA sont explicitement reliées, ce qui permet d’identifier rapidement les systèmes dont la finalité ou les données sensibles peuvent modifier le niveau de risque.